OpenAIオブザーバビリティ

OpenAIオブザーバビリティにより、自身のアプリケーションのOpenAI APIアクセス状況などを監視します。

OpenAI使用量を可視化することで、モデルごとのコスト、ログ、応答の分析を行い、エラーを特定します。

OpenAIオブザーバビリティの追加方法

OpenAIモジュールをインストールして追加を行います。

次の各フレームワークの手順を参照してください。

Node.js | Python

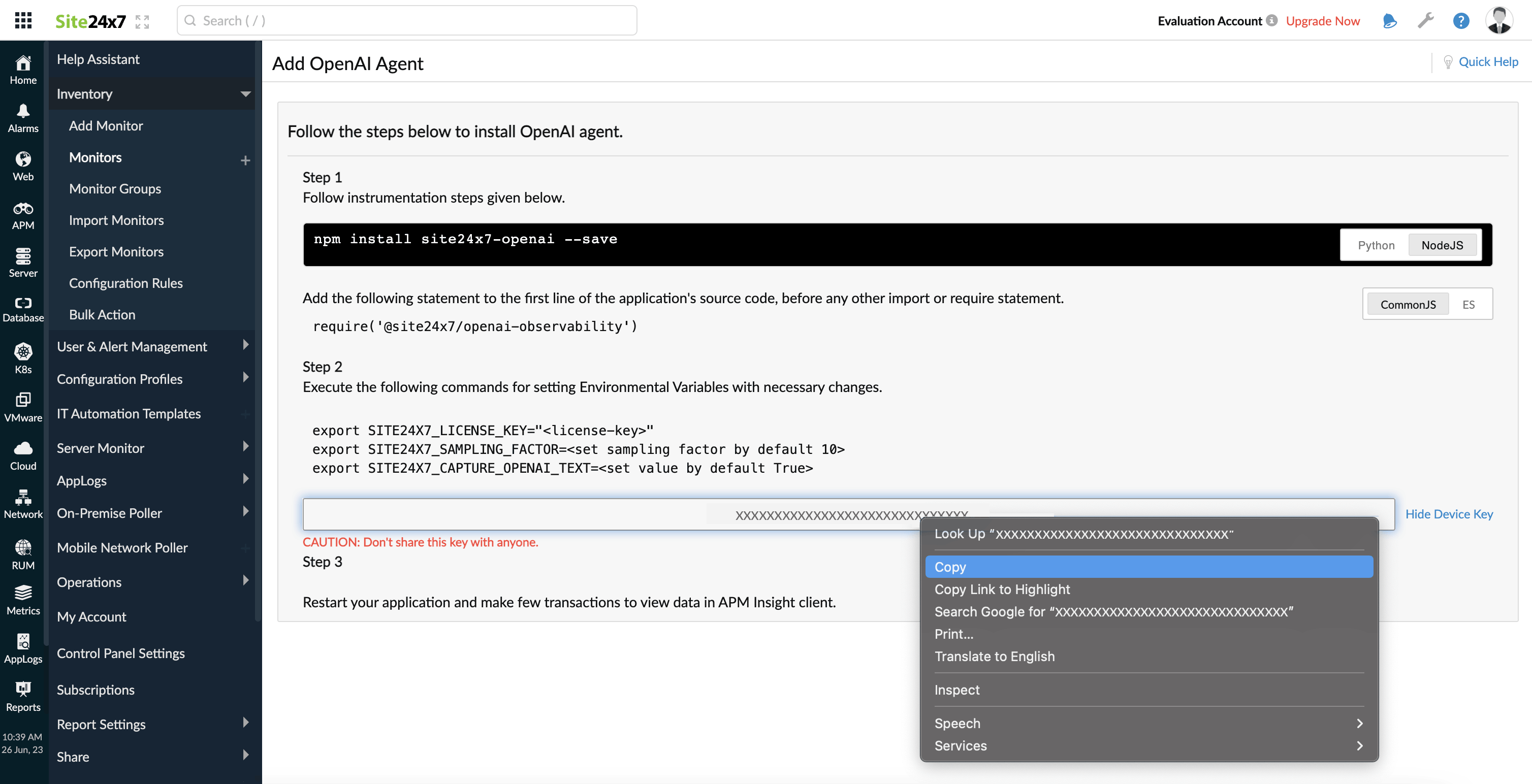

Node.js

- Node.jsアプリケーションを開きます。

- node package manager (NPM)にアクセスします。

- 次のコマンドを使用して、"site24x7 openai"モジュールをインストールします。

npm install @site24x7/openai-observability --save

- 次のコマンドをアプリケーションソースコードの最初の行に追加します。

- ESまたはTypescriptを使用している場合:

import * as site24x7-openai from '@site24x7/openai-observability'

- Common JSを使用している場合:

require('@site24x7/openai-observability')

- ESまたはTypescriptを使用している場合:

- Site24x7画面からライセンスキーをコピーします。

- ライセンスキーを次の環境変数に設定します。

SITE24X7_LICENSE_KEY=<コピーしたライセンスキー>

- アプリケーションを再起動します。

設定値を環境変数に指定します。

次のキーで、設定値を指定できます。

- SITE24X7_SAMPLING_FACTOR

- SITE24X7_CAPTURE_OPENAI_TEXT

- SITE24X7_SAMPLING_FACTOR:

デフォルトのサンプリングファクターは10です。監視間隔中のリクエスト10件の内の1プロンプトとメッセージのみをキャプチャします。

この値は変更することができ、例えば値を5に指定すると、5件のリクエストのプロンプトとメッセージの内、1件がキャプチャされるようになります。1と設定すると、すべてのリクエストのプロンプトとメッセージがキャプチャされます。 - SITE24X7_CAPTURE_OPENAI_TEXT:

- デフォルトで"True"に指定されており、サンプリングファクターを元にリクエスト内のプロンプトとメッセージがキャプチャされます。

- "False"に指定すると、このキャプチャは行われません。

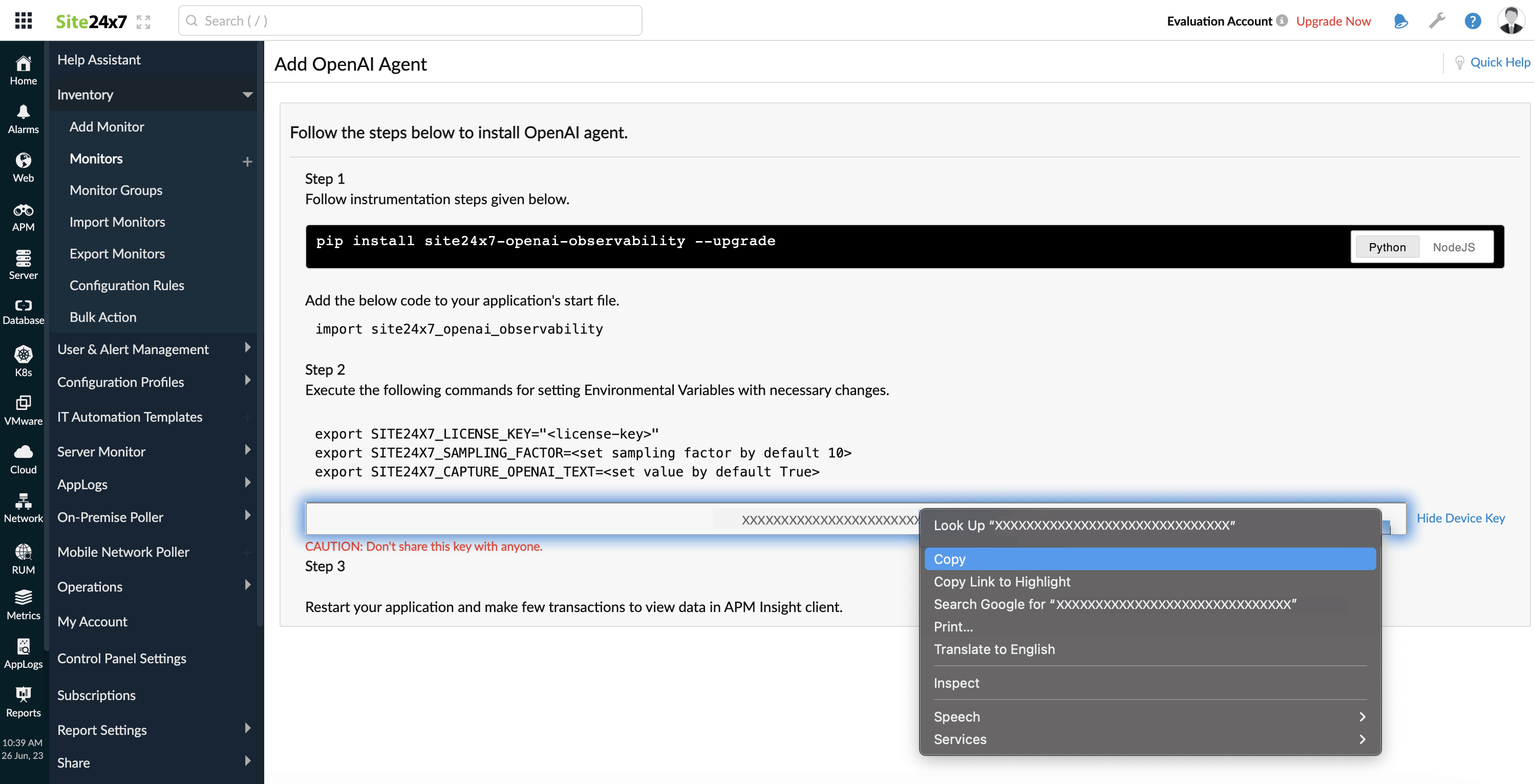

Python

- 次のコマンドで、"site24x7-openai"モジュールをインストールします。

pip install site24x7-openai-observability --upgrade仮想環境を使用している場合、アクティベート行ってから上記コマンドを実行し、環境に"site24x7-openai-observability"パッケージをインストールしてください。

- アプリケーションの起動ファイルに次のコードを追加して、オブザーバビリティエージェントを連携します。

import site24x7_openai_observability

- Site24x7画面からライセンスキーをコピーします。

- ライセンスキーを次の環境変数に設定します。

SITE24X7_LICENSE_KEY=<コピーしたライセンスキー>

- アプリケーションを再起動します。

追加設定:

サンプリングファクターとOpenAIテキストキャプチャを環境変数として設定するには、次のキーを使用します。

| 設定 | デフォルト値 | 説明 |

| $ export SITE24X7_SAMPLING_FACTOR=<set sampling factor> | 10 | デフォルトのサンプリングファクターは10です。監視間隔中のリクエスト10件の内の1プロンプトとメッセージのみをキャプチャします。 この値は変更することができます。 |

| $ export SITE24X7_CAPTURE_OPENAI_TEXT=<set value> | True |

|

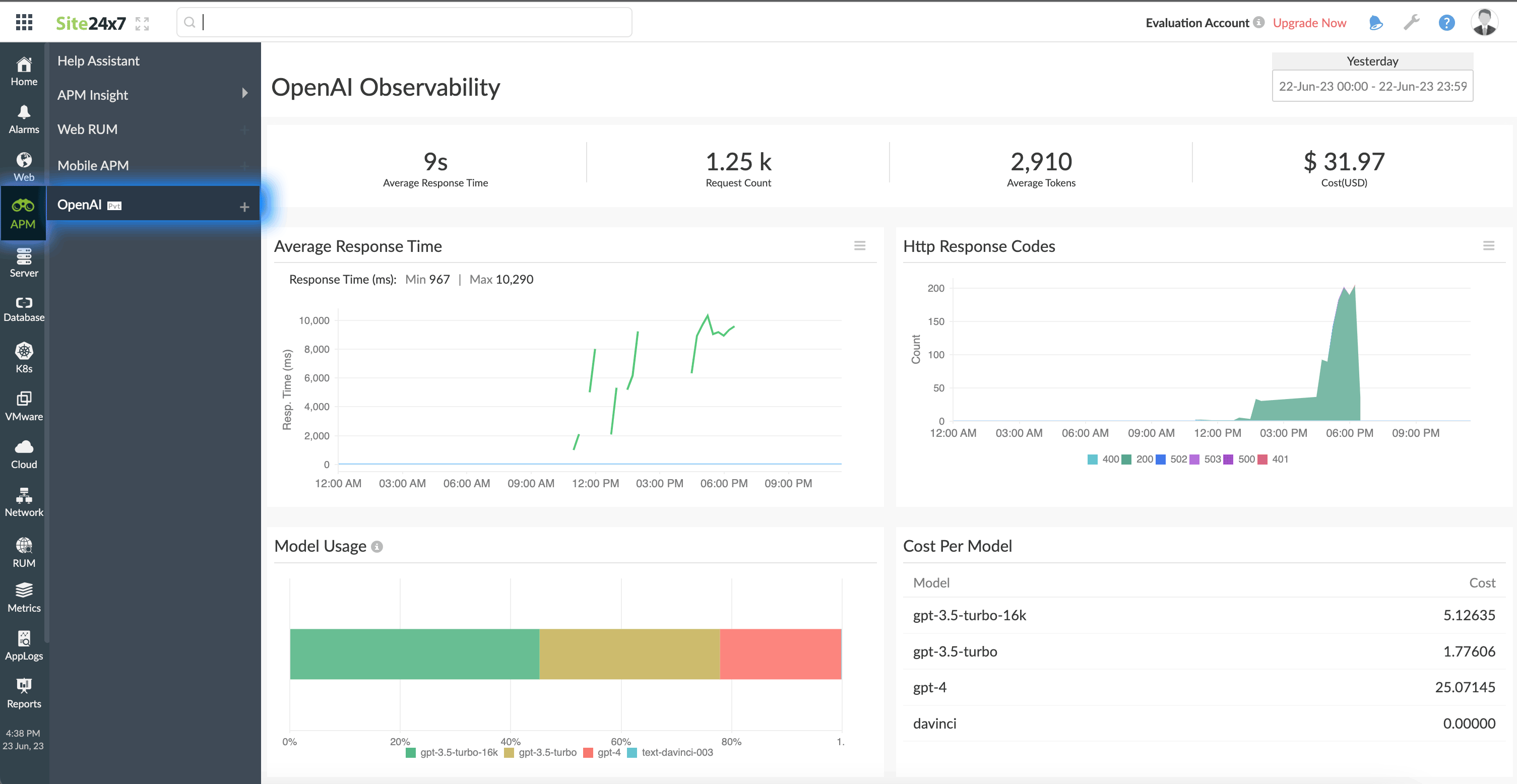

パフォーマンスメトリック

表示方法:

- Site24x7にログインします。

- [APM]→[OpenAI]に移動します。

右上の期間より、取得したいメトリックの表示期間を指定できます。

画面上部に平均応答時間、リクエスト数、平均トークン、コストが表示されます。

| パラメーター | 説明 |

| 平均応答時間 | OpenAIがユーザーリクエストの応答にかかった平均時間です。 |

| リクエスト数 | OpenAIに送信されたリクエスト数の合計です。 |

| 平均トークン | リクエストごとの平均トークン数です。

トークンは文字列です。

|

| コスト | かかったコストの合計です(USD単位)。 |

平均応答時間

選択した期間でのリクエストの平均応答時間を表示します。

[最小]は最小の応答時間、[最大]は最大の応答時間です。

HTTP応答コード

受信した各HTTP応答のサマリーです。

グラフにポインタを合わせるとその数を表示します。

モデル使用量

各モデルから送信されたリクエストパーセンテージを各ブロックで表示します。

ブロックは色分けされており、容易に特定が可能です。ブロックにポインタを合わせるとリクエスト数の合計を表示します。

コストごとのモデル

全モデルとそのコストのサマリーを表示します。

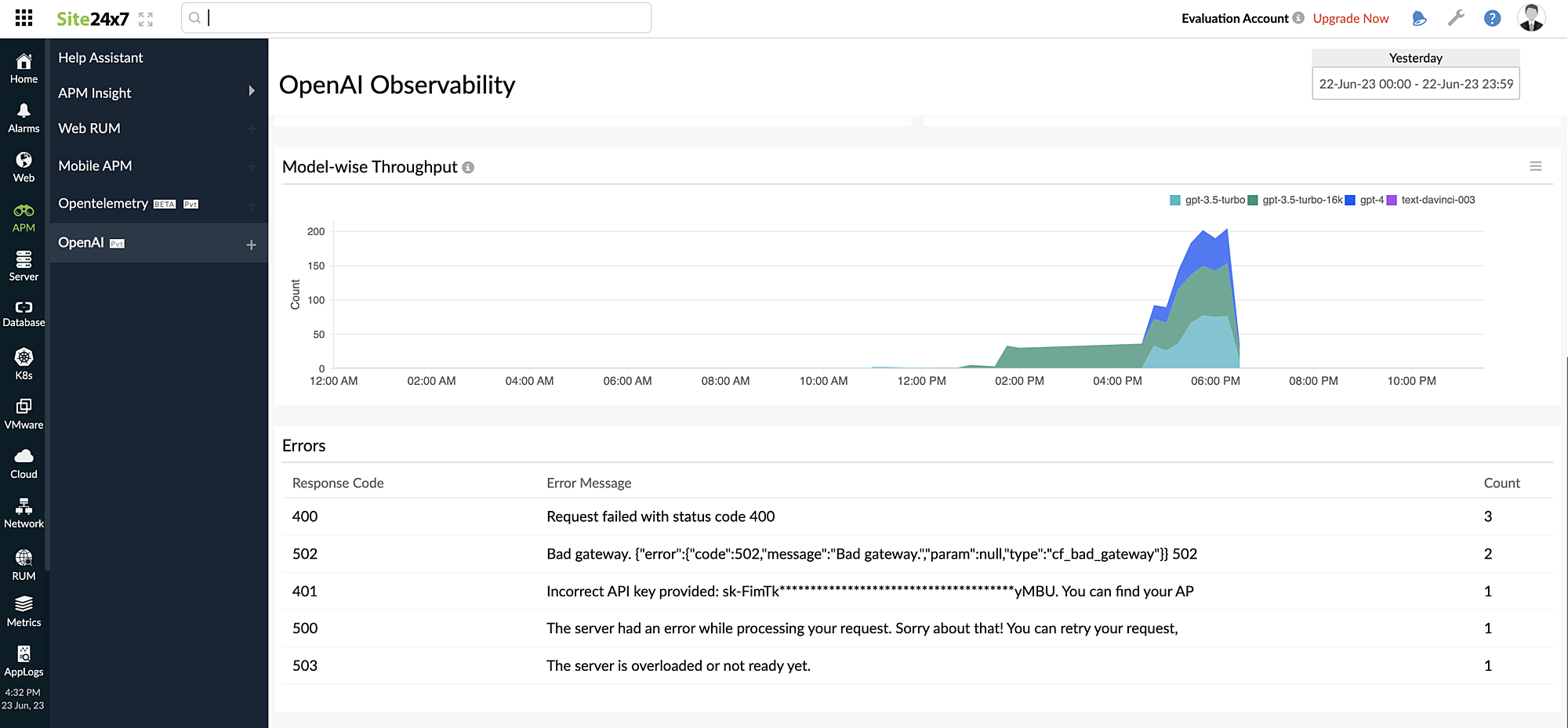

モデルごとのスループット

指定した期間で送信されたリクエストの合計を可視化します。

ポインタを合わせると、そのモデルのリクエスト数を表示します。

エラー

応答コード、エラーメッセージ、発生したエラー数のサマリーを表示します。

| パラメーター | 説明 |

| 応答コード | エラーのHTTP応答コードです。 |

| エラーメッセージ | 完全なエラーメッセージです。 |

| 数 | 発生したエラー数の合計です。 |